La transformación inevitable:

Data Lake House y la revolución de Big Data

La gestión de datos ha dejado de ser un componente secundario en el entorno empresarial, convirtiéndose en un factor crítico para la toma de decisiones estratégicas. A medida que la cantidad de datos generados alcanza proporciones titánicas, las arquitecturas de Big Data han evolucionado para enfrentar los desafíos de esta era digital.

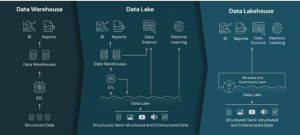

Este artículo se sumerge en la transformación silenciosa pero poderosa que ha dado lugar a tres paradigmas arquitectónicos: Data Warehouse, Data Lake y la innovadora Data Lakehouse. Se analizarán en detalle cada uno de estos enfoques, destacando sus fortalezas y limitaciones, y enfocándonos en la revolución que representa Data Lakehouse en el procesamiento de Big Data.

¿Qué es Big Data?

El término «Big Data» encapsula el fenómeno de la explosión de datos, caracterizado por sus tres V’s: Volumen, Velocidad y Variedad. Vivimos en una era donde la información fluye desde diversas fuentes a velocidades asombrosas, presentando una multiplicidad de formatos y estructuras.

- Arquitecturas para el Big Data: Una arquitectura de Big Data consiste en el diseño de sistemas y modelos para el tratamiento de grandes volúmenes de datos de diferentes tipos y orígenes con el fin de transformarlos en información enriquecida para soportar la toma de decisiones basadas en datos.

- Data Warehouse: Más allá de la fundación

La primera generación, representada por el Data Warehouse, surgió en los años 90 como una respuesta a la necesidad de analizar datos estructurados de manera eficiente. Su estructura centralizada y esquema predefinido ofrecían un rendimiento sólido y una integración de datos coherente. Sin embargo, con el tiempo, su rigidez estructural y limitaciones de escalabilidad revelaron fisuras en la adaptabilidad a la creciente diversidad de datos.

- Data Lake: Flexibilidad emergente, desafíos persistentes

La arquitectura de Data Lake, nacida hace aproximadamente una década, fue un paso audaz hacia la flexibilidad al permitir el almacenamiento de datos en su forma cruda, sin necesidad de estructuración previa. Este enfoque abrió la puerta a avances significativos en campos como el machine learning e inteligencia artificial. Aunque prometedor, la falta de estructura impuso desafíos considerables en la gobernanza y la capacidad de descubrimiento de datos.

- Data Lakehouse: Integración, flexibilidad y eficiencia

En el 2020, se reveló la arquitectura de Data Lakehouse como una respuesta a las limitaciones de sus predecesores. Buscando fusionar lo mejor de Data Warehouse y Data Lake, este enfoque se erige como la pieza central en el ajedrez de Big Data. Ofrece un equilibrio único entre la eficiencia estructurada del Data Warehouse y la flexibilidad del Data Lake. La capacidad de adaptarse a diversos tipos de datos, junto con su eficiencia en consultas analíticas, lo posiciona como el horizonte actual y futuro para proyectos de Big Data.

Imagen 1. Modelos arquitectónicos para Big Data

Fuente: https://databricks.com/blog/2020/01/30/what-is-a-data-lakehouse.html

Conoce más: Migración Exitosa hacia el Desarrollo en Tiempo Real con Kafka

Data Lake House en el Retail: Un caso práctico de transformación digital y beneficios estratégicos

El sector retail, siempre ágil en adoptar tecnologías emergentes, se encuentra en el epicentro de una transformación digital. Tradicionalmente aferrado a arquitecturas de Data Warehouse para el análisis de datos de ventas, inventario y clientes, el retail moderno se enfrenta al reto de gestionar la explosión de datos provenientes de transacciones en línea, dispositivos móviles y redes sociales.

La transición hacia un Data Lakehouse en este escenario permite el almacenamiento de datos no estructurados, desbloqueando la agilidad en el análisis sin la necesidad de etapas previas de transformación. La adopción del formato Delta Lake proporciona inmutabilidad, versionamiento y operaciones avanzadas como merge y upsert. Esto no solo garantiza la integridad de los datos, sino que también ofrece una mayor capacidad para analizar múltiples versiones simultáneamente.

La evolución de las arquitecturas de Big Data no es simplemente un fenómeno técnico; es una respuesta esencial a las demandas de un entorno empresarial dinámico y diversificado. Data Lake House no solo resuelve los desafíos de sus predecesores, sino que también plantea nuevas posibilidades para el análisis de datos en tiempo real y la toma de decisiones fundamentada en datos. A medida que nos adentramos en una era de transformación digital, la adopción de arquitecturas de Data Lake House se presenta como una estrategia inteligente y necesaria para las empresas que buscan no solo sobrevivir, sino prosperar en el vasto océano de datos contemporáneo.